Cobot per afferrare qualsiasi cosa

Ecco perché il vostro prossimo ordine su Amazon potrebbe essere confezionato da un braccio robot

Afferrare un oggetto è un’azione semplice per una persona, si tratta di un procedimento che svolgiamo quasi automaticamente, senza pensarci: ci allunghiamo, apriamo la mano e la richiudiamo per prendere ciò che ci serve. Anche se dietro queste operazioni si nasconde un lavoro molto complesso da parte del nostro cervello e dei nostri muscoli.

Ecco, questa complessità caratterizza da sempre l’operazione dei robot, dalla fase di programmazione a quella di movimentazione. Ma sembra che le cose stiano cambiando.

Infatti, presso la Queensland University of Technology (QUT) in Australia, un team di ricercatori ha messo a punto un metodo che consente ai cobot di afferrare un oggetto in modo veloce e accurato.

Lo stesso Dottor Jürgen Leitner, membro della ricerca e della Facoltà di Scienze ed Ingegnera della QUT, ha affermato che “prendere e spostare qualcosa è relativamente semplice per le persone, ma si tratta di compiti che si sono dimostrati molto ardui per i robot. Questo studio ha il potenziale per migliorare l’utilità dei robot tanto nel settore industriale quanto in quello domestico”.

Ma vediamo più nel dettaglio di cosa si tratta.

Un nuovo approccio per i bracci robot

L’obiettivo ultimo della ricerca è stato quello di, per usare ancora le parole del Dr. Jürgen, “creare robot che siano in grado di svolgere compiti utili nel mondo reale. Da diverso tempo ho il desiderio di fornire ai robot la capacità di interagire con il mondo attorno a loro, prendendo oggetti e spostandoli”.

È vero che diverse tecniche di apprendimento permettono già ai cobot di imparare migliaia di forme e dimensioni per calcolare il miglior modo di afferrare un oggetto sconosciuto in condizioni statiche.

Come viene spiegato in questo articolo del sito ‘The University Network’, generalmente i robot sfruttano una Rete neurale convoluzionale (CNN) che permette loro di individuare diversi campioni individualmente, e pensare al modo migliore per afferrarli. Questo sistema però richiede un lungo lasso di tempo dedicato al calcolo, persino per la lavorazione in ambienti statici.

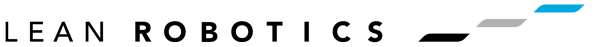

Il nuovo metodo ideato alla QUT di basa invece su una Rete neurale convoluzionale di afferramento generativo (GG-CNN), che effettua direttamente una scansione dell’ambiente circostante e mappa ogni pixel utilizzando un’immagine di profondità. Tutto questo in modo abbastanza veloce da riuscire a prendere degli oggetti in movimento.

Il video che ha pubblicato l’Università, in cui vediamo il cobot della Kinova in azione, permette di capire meglio questo concetto:

I test con i robot

Questo nuovo metodo è stato sviluppato dai ricercatori Douglas Morrison e Jürgen Leitner, e dal professore Peter Corke della facoltà di Scienze ed Ingegneria della QUT.

“L’approccio della Rete neurale convoluzionale di afferramento generativo permette di predire la qualità e la posizione di una presa con pinza. Mappando ciò che si trova di fronte a sé, il robot non ha la necessità di procedere per tentativi prima di prendere una decisione, evitando lunghi tempi di computazione” afferma il Dr. Morrison.

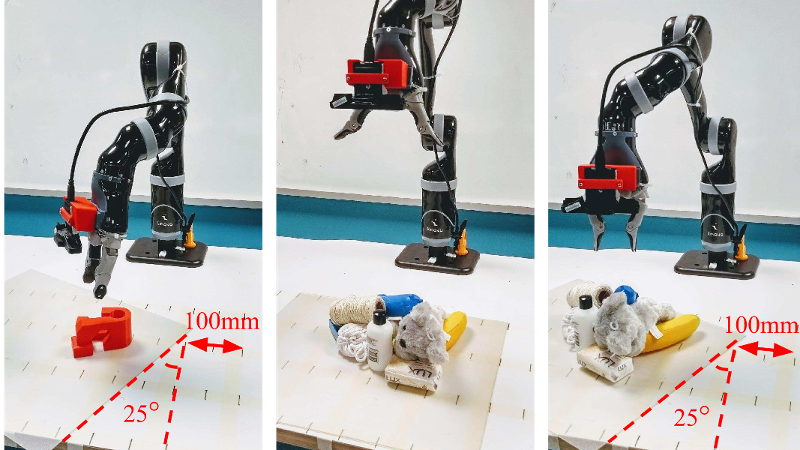

Il team di ricerca ha testato il nuovo approccio in diversi modi, utilizzando oggetti di uso domestico e stampe 3D, cominciando inizialmente con una serie di 10 test di presa su oggetti non visibili, in ambienti sia statici che in movimento.

Il cobot è riuscito ad ottenere un tasso di successo nella presa dell’84% con oggetti di geometrie contrapposte e del 92% con oggetti di uso domestico in un ambiente statico, e ha raggiunto rispettivamente l’83% e l’88% in un ambiente in movimento.

In un secondo momento gli oggetti sono stati mischiati in una scatola, creando una pila disordinata sotto il cobot in modo che ne prendesse uno ad uno, effettuando quindi un’altra serie di 10 test.

In questo caso il braccio è riuscito ad afferrare con successo i pezzi per l’87% dei casi in un ambiente statico e l’81% in un contesto in movimento.

Il Dr. Leiner ha affermato che questo nuovo approccio ha superato il numero di limitazioni delle tecniche di approfondimento profondo.

“Ad esempio all’ Amazon Picking Challenge, che il nostro team ha vinto nel 2017, il nostro robot CartMan guardava in un contenitore pieno di oggetti, decideva quale fosse il punto migliore di presa e quindi procedeva alla cieca cercando di afferrarli” spiega il Dr Leiner.

“Usando il nuovo metodo possiamo processare le immagini degli oggetti che il robot visualizza entro i 20 millisecondi, cosa che gli permette di aggiornare la sua decisione circa la posizione del punto di presa e poi agire, cosa particolarmente importante in ambienti disordinati” conclude il ricercatore.

I prossimi passi

I ricercatori della QUT sperano di migliorare ulteriormente il loro metodo, così che possa essere utilizzato ampiamente e in sicurezza tanto in ambienti industriali quanto in quelli domestici.

Il Dr. Leiner ha infatti affermato che “questa linea di ricerca ci permette di utilizzare sistemi robotici non solo in ambienti strutturati, dove l’intero spazio è stata costruito per rispondere alle capacità del robot. Ci consente di afferrare oggetti anche in ambienti non strutturati, dove le cose non sono perfettamente ordinate e pianificate e al robot è richiesto di adattarsi al cambiamento. Questo comporta dei benefici per l’industria in generale, passando dai magazzini per lo shopping online o per lo smistamento merci per arrivare alla presa di frutta e verdura. Ma il campo di applicazione si estende anche alla sfera domestica, dato che robot sempre più intelligenti vengono utilizzati non solo per pulire i pavimenti, ma anche per prendere degli oggetti e metterli a posto”.

Gli utilizzi pratici di questa scoperta sono pertanto moltissimi, ma come sopradetto il team sta continuando a lavorare, perseguendo l’obiettivo di realizzare metodi sempre più innovativi. Ad esempio cercando di superare le limitazioni che ancora sussistono nell’approccio corrente, come la visione dei cobot e capacità manipolatorie in una varietà di ambienti.

Gli sviluppi sono certamente interessanti, e li seguiremo con attenzione.